IA Generativa - o poder criativo da IA

A IA Generativa, ou Inteligência Artificial Generativa, refere-se a sistemas de IA capazes de gerar conteúdo novo. Esses sistemas usam algoritmos para analisar grandes quantidades de dados, aprender com eles, sendo então capazes de gerar novos dados que seguem o mesmo padrão dos dados de treinamento. Isso pode incluir texto, imagens, música, voz, vídeos e outros tipos de mídia.

A IA Generativa é interessante porque pode auxiliar na criação de arte, na resolução de problemas complexos de maneiras inovadoras e na automatização de tarefas criativas. Mas também levanta questões éticas, como a possibilidade de criar "deepfakes" ou conteúdo enganoso.

Os métodos mais comuns usados nesse tipo de IA , são:

- Modelos de linguagem: são especializados em gerar texto. Eles são treinados com grandes volumes de texto e aprendem a prever a próxima palavra ou frase que segue logicamente, permitindo-lhes gerar parágrafos de texto coerente e relevante com base em um prompt. Esse tipo de modelo se tornou popular por conta do ChatGPT e é o foco desse artigo.

- Redes Generativas Adversariais (GANs): as Generative Adversarial Networks consistem em duas redes neurais que competem entre si: o gerador, que cria dados, e o discriminador, que avalia se os dados são reais (do conjunto de treinamento) ou falsos (criados pelo gerador). O objetivo é que o gerador aprenda a produzir dados cada vez mais convincentes.

- Autoencoders Variacionais (VAEs): os Variational Autoencoders são usados para gerar dados que são semelhantes aos que eles foram treinados, mas com variações. Eles são frequentemente usados em processamento de imagens, como em programas de edição de fotos que podem alterar a expressão facial de uma pessoa.

- Modelos de Síntese de Voz: São capazes de gerar fala que soa como um humano falando, podendo até imitar vozes específicas após o treinamento em amostras de áudio.

Modelos de linguagem

Como vimos anteriormente, os modelos de linguagem são sistemas de inteligência artificial que aprendem a processar e gerar linguagem natural a partir de vastas quantidades de texto. Durante o treinamento, eles desenvolvem a capacidade de prever a próxima palavra em uma sequência baseando-se no contexto das palavras anteriores. Isso é feito via aprendizado supervisionado, onde o modelo é continuamente ajustado para melhorar a precisão das suas previsões.

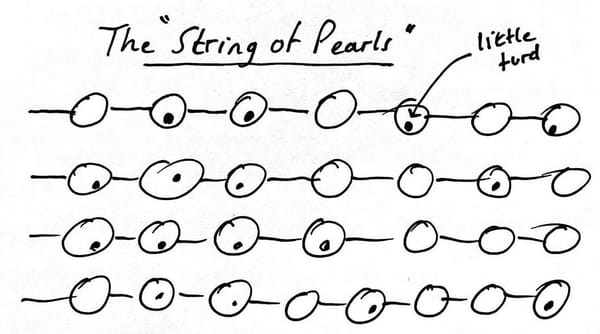

Esses modelos podem ter diferentes arquiteturas. Por exemplo, os modelos de Transformer, como o GPT (Generative Pre-trained Transformer), usam uma arquitetura que permite que o modelo “preste atenção” a diferentes partes da entrada (prompt) ao fazer previsões. Isso é chamado de mecanismo de atenção, que ajuda o modelo a se concentrar em informações relevantes e ignorar o resto. Esses modelos também aprendem representações complexas de palavras e frases, convertendo-as em vetores numéricos que capturam nuances semânticas e gramaticais.

Já para gerar texto, um modelo de linguagem utiliza o que foi aprendido durante o treinamento para calcular a probabilidade das palavras subsequentes, criando sequências de texto coerentes e contextuais. Este processo pode ser ajustado para promover diversidade e criatividade na geração de texto.

Há uma medida de criatividade e variação no processo de geração de texto, pois o modelo pode ser programado para escolher palavras com base não apenas na maior probabilidade, mas também explorando opções menos prováveis. Isso introduz diversidade no texto gerado e evita a repetição. O modelo pode até ser ajustado para imitar estilos literários específicos ou cumprir determinados parâmetros criativos, tornando a ferramenta extremamente versátil.

Quem já usou o ChatGPT sabe o quão convincente é a escrita produzida e apesar da sua capacidade de gerar texto ter um resultado excepcional, é importante reconhecer que esses modelos operam com base em padrões e correlações estatísticas, não em compreensão consciente. Eles carecem de consciência e não possuem conhecimento do mundo real além dos dados com os quais foram treinados. Consequentemente, eles podem produzir texto que parece plausível, mas que pode ser factualmente incorreto ou sem sentido, o que é uma limitação importante a ser considerada pelos usuários dessas tecnologias.

Por fim, os modelos podem ser especializados via ajuste fino com dados de treinamento específicos, melhorando seu desempenho em tarefas particulares e apesar de realmente os modelos gerarem conteúdo novo, eles não criam algo de fato, eles são comandados por um prompt, ou seja, são uma ferramenta que agiliza o trabalho de alguém que está coordenando essa criação.

Quer algumas dicas de como interagir com o GPT e extrair melhores resultados?

Veja esses artigos que escrevi aqui no site:

Engenharia de prompt: a ponte entre linguística e computação