Multiagentes em 5 min

Agentes de IA são promissores, mas não fazem mágica. Sem uma arquitetura sólida, viram só hype. Este artigo analisa os limites e potenciais dos sistemas multiagentes e propõe uma visão prática: tecnologia boa é a que resolve problema real — com engenharia de verdade.

Imagine o seguinte cenário: é segunda-feira, início da manhã. Você chega ao escritório, pega seu café e, antes de abrir o notebook, percebe uma agitação diferente na equipe. Todo mundo fala sobre a última novidade do mercado de IA: sistemas multiagentes. Alguns comentam sobre projetos revolucionários, outros já pensam em reorganizar o backlog da sprint para “não ficar pra trás”.

Você observa a empolgação, mas também sente aquele frio na barriga de quem já viu muitos modismos passarem — e sabe que, no fim das contas, o que faz as empresas avançarem de verdade é menos glamour e mais engenharia sólida.

Enquanto escuta um colega explicar animado como “agora é diferente”, você se lembra: quantas vezes uma buzzword já prometeu mudar o jogo… mas, é mais uma tinta fresca sobre uma parede antiga.

É nesse clima, entre o entusiasmo do novo e a experiência do que já funciona, que surgem os sistemas multiagentes — e é sobre como encarar essa tendência sem perder o foco (e sem reinventar a roda) que conversaremos a seguir.

Tenho um cliente que apareceu com um problema bem concreto: automatizar partes do seu processo de suporte interno, com ajuda de IA generativa. A ideia era ambiciosa — queria que o sistema entendesse solicitações, tomasse decisões simples e até acionasse ferramentas automaticamente.

Logo, sistemas multiagentes virou o novo mantra das salas de reuniões. Parecia promissor. Havia frameworks novos, comunidades discutindo, startups inteiras apostando nisso. A empolgação era grande. Mas, como bons engenheiros, decidimos ir além do hype e ver o que isso realmente significava na prática.

Vou te contar como resolvemos isso em partes:

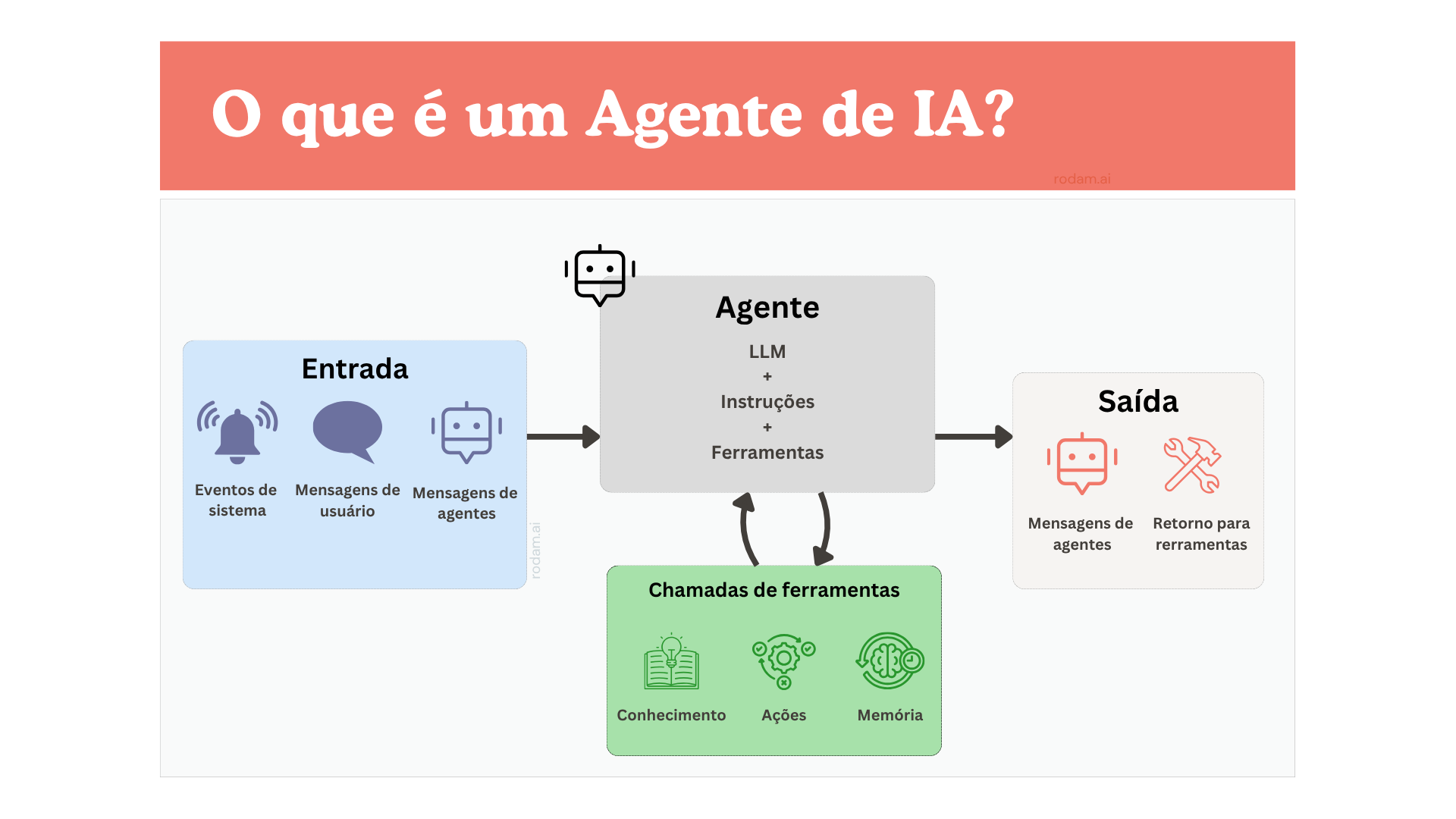

Parte 1: Definindo “agente de IA”

Nosso primeiro passo foi tentar entender o que exatamente era um “agente” nesse contexto. Em uma apresentação de um gerente de produto da Microsoft, um vi um diagrama mostrando que o agente era uma função que recebia uma entrada (texto), processava com um LLM, fazia uma chamada de API se necessário, e devolvia uma resposta.

Olhei para aquilo e pensei: “isso é um microsserviço com uma chamada a um modelo de linguagem.”

Não era só uma impressão — era literalmente isso. Aqueles “agentes” nada mais eram do que unidades de código com responsabilidade clara, muitas vezes stateless, se comunicando por mensagens, e com lógica de fallback em caso de erro. Você pode ver essa definição e em maiores detalhes aqui.

Etapa 2: Implementando na prática

Uma vez definido o que era, dividimos o sistema em “papéis”: um agente planejador, outro executor de comandos, um validador semântico, e por aí vai. Logo estávamos com um fluxo orquestrado, em que cada agente recebia tarefas específicas, acessava ferramentas externas e mantinha um pequeno estado interno.

Parecia novo? Até certo ponto. Mas estruturalmente, estávamos replicando os mesmos padrões de arquitetura de microsserviços que já usávamos em outros sistemas:

- Separação de responsabilidades

- Comunicação via mensagens

- Orquestração centralizada

- Lógica de resiliência e monitoramento

Etapa 3: A comparação inevitável

Na minha cabeça a comparação foi inevitável, nesse ponto que decidimos mapear explicitamente as similaridades:

| Sistemas Multiagentes | Microsserviços Tradicionais | |

|---|---|---|

| Origem da lógica | Baseada em comportamento e tomada de decisão contextual | Baseada em regras e fluxo determinístico |

| Papel do modelo de IA | Elemento central que interpreta e age sobre linguagem | Complementar (se usado), geralmente fora da lógica principal |

| Tipo de entrada processada | Linguagem natural, dados ambíguos, instruções abertas | Dados estruturados, contratos bem definidos |

| Nível de imprevisibilidade | Alto — agentes podem gerar saídas inesperadas | Baixo — comportamento mais previsível e controlado |

| Forma de adaptação | Adapta-se com base no contexto sem reimplantação | Requer mudanças no código e novo deploy |

| Papel do orquestrador | Coordena decisões entre agentes com base em feedback | Orquestra tarefas com fluxo já predefinido |

| Uso típico | Automação cognitiva, atendimento inteligente, workflows flexíveis | Processamento transacional, APIs, serviços core |

| Custo de observabilidade | Mais complexo — tracking semântico, decisões não lineares | Menos complexo — rastreamento baseado em logs e tracing técnico |

| Desafio principal | Controlar variabilidade e alinhar expectativa de resultado | Gerenciar integração e acoplamento entre serviços |

Essa análise ajudou o time a entender que não estávamos adotando um novo paradigma — estávamos apenas adicionando modelos de linguagem como mais um tipo de serviço cognitivo na arquitetura já existente.

Por padrão, microsserviços são pensados para clareza, autonomia e resiliência. Eles sustentam a espinha dorsal de muitas arquiteturas modernas e já provaram seu valor. Eu já falava disso há anos, tinha uma palestra chamada "Microsserviços prontos para produção" que apresentei em alguns lugares, inclusive na Python Brasil de 2019.

Orquestração de multiagentes de IA: funcionamento e protocolos

Deixemos essa comparação com microsserviços de lado por um momento e vamos focar mais na questão dos agentes de AI em si. A orquestração desses agentes permite, cada um com deles, funções e habilidades específicas, colaborem para resolver tarefas complexas. Porém, para que essa cooperação aconteça de forma eficiente, protocolos de comunicação padronizam e coordenam a interação entre eles.

Caso queira entender o conceito de protocolo, leia este artigo que escrevi: Protocolos.

Dois protocolos em destaque: A2A e MCP

Hoje, os grandes protagonistas dessa comunicação eficiente entre agentes de IA são dois protocolos: o A2A (Agent-to-Agent), criado pelo Google, e o MCP (Model Context Protocol), lançado pela Anthropic. Apesar de atuarem no mesmo jogo, eles estão em posições diferentes, e é isso que explico a seguir.

O que é o protocolo Agent-to-Agent(A2A)?

Pense no A2A como uma espécie de língua universal para agentes de IA — como se fosse o “HTTP” do universo dos agentes. Ele foi criado para que sistemas de IA possam conversar, negociar e dividir tarefas, mesmo que tenham origens, plataformas ou fornecedores diferentes. Ele possibilita aos agentes:

Se descobrirem e se apresentarem

Compartilharem o que sabem fazer

Coordenarem e negociarem o que cada um vai executar

Trocarem informações e resultados, sempre de modo seguro e eficiente

Algumas peças-chave nesta dinâmica:

Agent Cards: o “cartão de visita” dos agentes, detalhando suas habilidades e como interagir com eles, tudo em formato digital.

Tasks e Artifacts: organizam as tarefas e padronizam os resultados, garantindo que tudo flua.

Mensageria modular: suporta vários tipos de mensagens, de textos a arquivos estruturados.

Comunicação assíncrona: com tecnologias como HTTP, JSON-RPC e SSE.

Desta forma, diferentes agentes, de plataformas diversas, conseguem trabalhar juntos sem tropeços, apenas implementando esse protocolo.

Model Context Protocol (MCP): uma interface universal

Agora, imagine o MCP como um “conector universal”, tipo um cabo USB-C capaz de ligar qualquer coisa. O MCP foi criado para que agentes e modelos de IA possam acessar bancos de dados, APIs e plataformas externas, tudo de forma padronizada e otimizada.

Por que isso importa?

Porque dá ao agente contexto real, como histórico de ações e dados do ambiente.

Coloca o agente como cliente, que pode buscar informações em diferentes servidores sem complicação técnica.

Permite que o agente amplie suas capacidades acessando facilmente novas ferramentas, dados e sistemas externos.

Ou seja, um agente com MCP acessa praticamente tudo que precisa para entregar resultados mais ricos, assertivos e personalizados.

Diferenças na prática: A2A x MCP

Sabendo disso, fica fácil entender porque esses dois protocolos, mesmo sendo essenciais, servem para propósitos distintos:

| Característica | A2A | MCP |

|---|---|---|

| Foco | Comunicação entre agentes de IA (horizontal) | Integração com ferramentas externas |

| Arquitetura | Peer-to-peer (agente para agente) | Cliente-servidor (agente acessando recursos) |

| Casos de uso | Coordenação entre agentes autônomos | Agente acessando bancos de dados, APIs, sistemas |

| Exemplo | Agente de agenda aciona o de e-mail para convites | Agente consulta dados em sistema externo |

| Comunicação | Assíncrona via HTTP, JSON-RPC, SSE | JSON-RPC, integração padronizada com serviços |

| Objetivo | Colaboração direta entre múltiplos agentes | Ampliar o contexto via recursos externos |

Resumindo de forma simples, o protoclo A2A permite a colaboração direta entre agentes de IA, enquanto o MCP conecta esses agentes a recursos externos, tornando ambos complementares e essenciais para ecossistemas de IA mais eficientes e integrados.

Em vez de trocar o motor, estamos adicionando sensores

No fim das contas, o que chamamos hoje de “sistemas multiagentes” nada mais são do que composições modernas dentro de arquiteturas já bem compreendidas. Ao invés de descartar conceitos sólidos como microsserviços, estamos apenas os expandindo com novas possibilidades cognitivas, proporcionadas pelos modelos de linguagens.

Quando bem projetados, podem acelerar processos, melhorar interações e até antecipar necessidades. Mas continuam sendo parte de um sistema maior, que precisa ser bem arquitetado, testado e mantido.

A narrativa dos agentes de IA serem “um time de especialistas” que funciona 24h pode ser útil para gerar alinhamento com lideranças, vender a ideia e garantir adesão interna. Mas, para quem constrói sistemas no dia a dia, a real vantagem está em usar a maré alta para impulsionar o barco, sem comprometer a base técnica.

Não se trata de uma revolução, mas de uma evolução pragmática — onde o conhecimento já consolidado sobre escalabilidade, resiliência e modularidade continua sendo o alicerce, agora turbinado com novas capacidades semânticas.

Quer explorar como integrar agentes inteligentes ao seu ecossistema sem abrir mão da solidez dos microsserviços? Comece pequeno. Identifique um fluxo com ambiguidade alta, implemente um agente, observe os ganhos e itere.

Seu stack, provavelmente, já está pronto para essa conversa — só falta o primeiro passo.