Streaming de dados

Explorando o streaming de dados: desafios, tecnologias e impacto no mundo real.

Imagine um mundo onde decisões críticas precisam ser tomadas em frações de segundo - um mundo onde cada clique, cada transação e cada sinal transmitido por dispositivos ao nosso redor gera um rio de informações que flui incessantemente. Bem-vindo ao fascinante universo do streaming de dados. Em uma era dominada pela velocidade e pela quantidade de informações, a habilidade de processar e analisar dados em tempo real não é apenas um luxo, mas uma necessidade imperativa. O streaming de dados está no coração dessa revolução, capacitando organizações a capturarem o momento e agirem com precisão e agilidade sem precedentes.

Mas o que realmente significa 'streaming de dados'? E por que ele se tornou tão crucial para engenharia de dados? Este artigo é o primeiro de uma série, e nele vou explorar seu significado e importância, as tecnologias que o tornam possível, os desafios envolvidos e as inúmeras aplicações que transformam nossa maneira de viver e trabalhar.

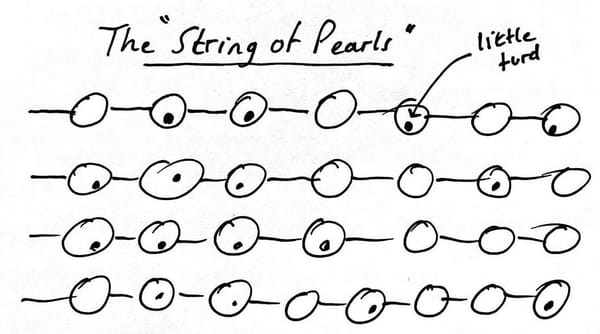

O streaming de dados é um conceito fundamental na engenharia de dados e no campo de big data, caracterizado pelo processamento e análise contínua de fluxos de dados em tempo real. Este paradigma difere significativamente do processamento de dados em lote, que lida com a manipulação de dados em blocos, geralmente após a coleta dos dados. O streaming de dados refere-se à capacidade de processar continuamente dados gerados em alta velocidade por diversas fontes. Estes dados podem vir de uma ampla variedade de fontes, como sensores em dispositivos IoT (Internet das Coisas), logs de servidores, transações financeiras, feeds de mídia social e muito mais. O aspecto chave é que os dados são criados, capturados, processados e utilizados quase instantaneamente.

Qual a importância do streaming de dados?

Após entender o que é streaming de dados, você pode estar se perguntando por que ele é tão crucial no mundo atual. Vamos entender sua importância e descobrir como ele está remodelando a tomada de decisão em negócios e tecnologia.

Hoje em dia, a quantidade de dados gerados por minuto é imensa e continua crescendo. Ele permite às organizações analisar e reagir a informações em tempo real, o que é crucial para tomadas de decisão rápidas e eficientes. Por exemplo, na detecção de fraudes financeiras, a análise em tempo real dos padrões de transação pode identificar e impedir atividades fraudulentas imediatamente.

Tecnologias envolvidas

Uma vez que entendemos a importância dessa análise de dados em tempo real, tendemos a pensar em quais tecnologias podem apoiar a adoção dessa abordagem. Para facilitar o streaming de dados, várias tecnologias são empregadas. Ferramentas como Apache Kafka, Apache Flink, Apache Storm e plataformas de nuvem como Azure EventHubs, Confluent e AWS Kinesis são projetadas para lidar com grandes volumes de dados em tempo real, garantindo baixa latência e alta confiabilidade. Estas ferramentas fornecem a infraestrutura necessária para coletar, processar e analisar fluxos de dados contínuos.

Essas ferramentas, cada uma a sua maneira, facilitam o trabalho do time de engenharia de dados, seja abstraindo as peculiaridades das diversas fontes de dados, ou ainda trazendo controle ao processo, não pretendo esmiuçar os detalhes de cada uma delas nesse post, porém seu uso torna o processo de movimentação e análise de dados mais ágil, respeitando todos os requisitos de governança como privacidade, segurança, qualidade, rastreabilidade e demais requisitos não funcionais de gestão pertinentes a criação de um sistema profissional de análise de dados. O uso de cada uma delas, ou de outras tantas, deve se basear na necessidade do projeto e como qualquer tecnologia que será empregada, precisa ser avaliada pelo time técnico responsável.

Desafios

Embora as tecnologias de streaming de dados ofereçam soluções transformadoras, a implementação e gestão desses sistemas vêm com uma série de desafios significativos. Aqui estão alguns dos obstáculos mais comuns que as equipes enfrentam ao navegar no mundo do processamento de dados em tempo real:

Gestão de Volume e Velocidade de Dados: O primeiro grande desafio é lidar com o imenso volume e a alta velocidade dos dados gerados. As organizações precisam de sistemas que não apenas processem esses dados quase instantaneamente, mas que também sejam capazes de escalar conforme a demanda, garantindo que nenhum dado valioso seja perdido ou atrasado.

Garantia de Qualidade e Integridade dos Dados: Manter a qualidade e a integridade dos dados em um fluxo contínuo é complexo. Erros, duplicidades ou inconsistências podem comprometer a análise. Portanto, é essencial implementar processos de validação e limpeza em tempo real, embora isso possa representar um desafio considerável dada a natureza dos dados.

Complexidade de Processamento e Análise: Desenvolver algoritmos capazes de processar e analisar esses dados em tempo real, muitas vezes utilizando técnicas de aprendizado de máquina, exige uma combinação de expertise técnica avançada e recursos computacionais significativos, colocando a complexidade de processamento e análise como um desafio crítico.

Gerenciamento de Infraestrutura e Escalabilidade: A necessidade de uma infraestrutura resiliente, altamente disponível e escalável implica em desafios de configuração, gestão e otimização de custos. Essa infraestrutura deve ser capaz de se adaptar a picos de dados inesperados sem comprometer a performance.

Segurança e Privacidade dos Dados: Em uma era de regulamentações rigorosas de proteção de dados, assegurar a privacidade e a segurança dos dados processados é imperativo. Isso envolve a implementação de medidas de segurança robustas, como criptografia e controles de acesso, sem prejudicar a eficiência do processamento de dados.

Adaptação a Mudanças de Esquema: A flexibilidade para se adaptar a mudanças de esquema nos dados de entrada é crucial, especialmente à medida que novas fontes de dados são integradas e os requisitos evoluem. Isso requer uma arquitetura de sistema que suporte alterações dinâmicas sem necessidade de interrupções ou reformulações extensas.

Cada um desses desafios destaca a necessidade de uma abordagem cuidadosa na adoção do streaming de dados, exigindo não apenas a escolha das tecnologias adequadas, mas também um planejamento detalhado e uma execução atenta. Ao superar esses obstáculos, as organizações podem maximizar o valor do streaming de dados, aproveitando sua capacidade de oferecer insights em tempo real e tomar decisões baseadas em dados com rapidez e eficácia.

Onde aplicamos?

Apesar desses desafios, o streaming de dados tem uma quantidade de aplicações práticas, tão variadas quanto impressionantes. Vamos agora examinar como essa tecnologia está sendo aplicada em diferentes setores para transformar completamente suas operações.

Além da detecção de fraude já mencionada, outras aplicações incluem monitoramento de infraestrutura de TI, análise de sentimento em mídias sociais, monitoramento ambiental, telemetria de frota e de veículos autônomos, acompanhamento de sinais de saúde e muitas outras.

Através deste panorama, fica claro que o streaming de dados é um catalisador para a mudança em muitas indústrias. Para concluir, refletiremos sobre o impacto duradouro e o futuro potencial desta tecnologia fascinante.

Ao avançarmos em direção a um futuro cada vez mais digitalizado e interconectado, o streaming de dados não é apenas uma abordagem inovadora - é uma visão essencial que molda a maneira como as organizações se preparam para tratar a crescente demanda por decisões mais ágeis baseadas em dados. As possibilidades que se abrem são tão vastas quanto o próprio campo de dados. De melhorar a precisão e a eficiência na tomada de decisões a abrir novos caminhos em áreas como inteligência artificial e aprendizado de máquina, o streaming de dados está no centro de uma revolução de dados que continua se desdobrando.

À medida que enfrentamos os desafios do presente e olhamos para as oportunidades do futuro, uma coisa é clara: a fluidez, a velocidade e a adaptabilidade proporcionadas pelo streaming de dados serão fundamentais em uma ampla gama de aplicações. Seja na detecção de fraudes, no monitoramento ambiental ou na otimização de experiências de usuário em tempo real, as capacidades do streaming de dados já estão redefinindo os limites do possível.

Contudo, como qualquer tecnologia emergente, o streaming de dados continua a evoluir. As organizações que adotarem essa tecnologia devem permanecer ágeis, prontas para se adaptar às novas tendências e mudanças. A educação contínua e a atualização de habilidades serão cruciais para profissionais da área que desejam se manter à frente na corrida pela inovação.

Você está pronto para mergulhar mais fundo no mundo do streaming de dados? Seja você um profissional da área procurando se atualizar sobre as últimas tendências ou alguém apenas curioso sobre como essa tecnologia está remodelando nosso mundo, convido você a se juntar à discussão. Deixe um comentário abaixo com suas ideias, perguntas ou experiências relacionadas ao streaming de dados. Vamos explorar juntos as possibilidades ilimitadas que essa tecnologia oferece.

Além disso, se você está procurando aprofundar seu conhecimento ou necessita de orientação especializada para implementar soluções de streaming de dados em sua organização, não hesite em entrar em contato. Estou aqui para ajudar você a navegar neste emocionante campo e a aproveitar ao máximo o poder dos dados em tempo real.